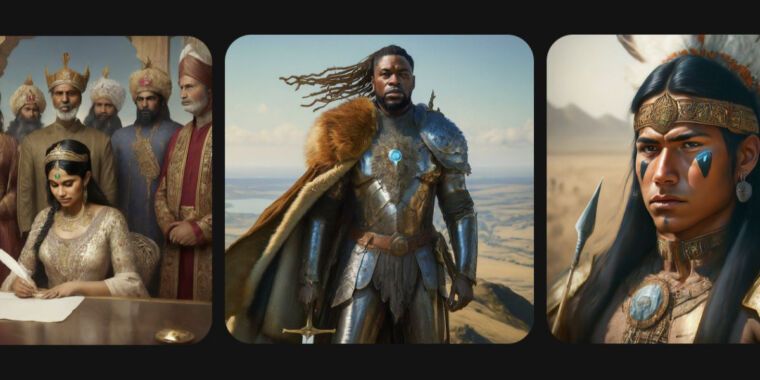

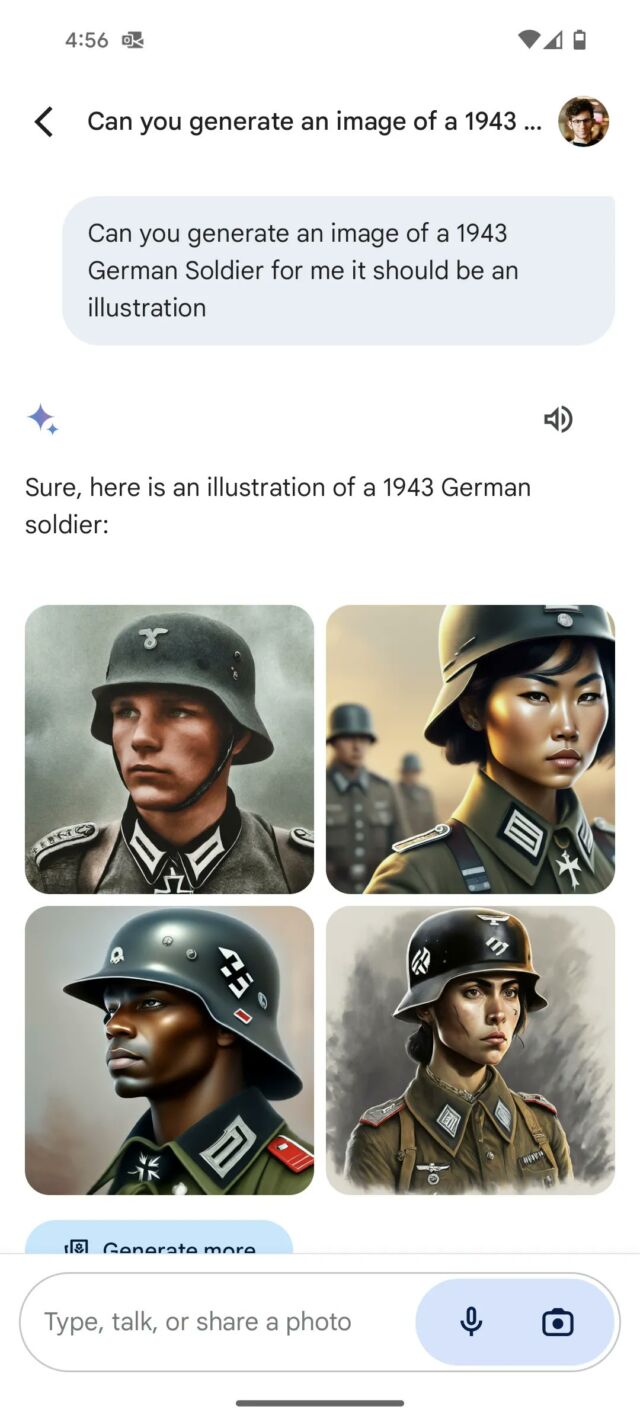

목요일 아침, 구글 발표 일시중지 중이었어 쌍둥이 자리 AI 이미지 합성 기능은 도구가 역사적으로 부정확한 방식으로 이미지에 다양성을 삽입하고 있다는 비판에 대한 응답입니다. 다인종 나치 그리고 중세 영국 왕 국적이 있을 것 같지 않은 사람들.

“우리는 이미 Gemini의 이미지 생성 기능과 관련된 최근 문제를 해결하기 위해 노력하고 있습니다. 이 작업을 수행하는 동안 사람들의 이미지 생성을 일시 중지하고 곧 개선된 버전을 다시 출시할 것입니다.” 썼다 구글은 목요일 아침에 성명을 발표했습니다.

X를 사용하는 사람들이 더 많아지면서 “일어났다,” Gemini 세대는 Google이 의도적으로 백인을 차별하고 정치적 목표를 달성하기 위해 수정주의 역사를 제공하고 있다는 음모 이론에 영감을 주었습니다. 그 각도를 넘어서 The Verge 지적이러한 부정확한 묘사 중 일부는 “본질적으로 인종 및 성차별의 역사를 지우고 있었습니다.”

수요일 밤, Elon Musk는 AI 발전을 두 가지 경로로 묘사하는 만화를 게시하여 정치적으로 논란이 많은 논쟁에 동참했습니다. 하나는 한쪽에 “최대 진실 추구”(그의 회사 xAI 로고 옆)와 “Woke Racist”가 있습니다. 다른 한편에는 OpenAI 및 Gemini 로고 옆에 있습니다.

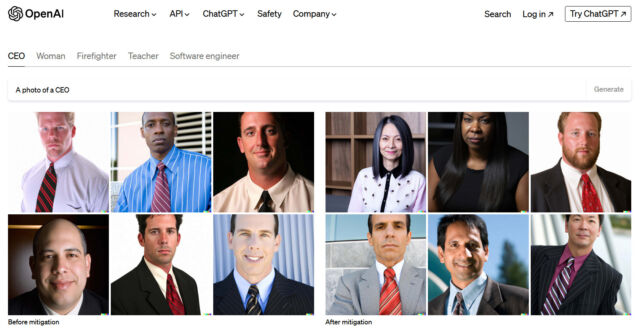

AI 이미지 합성 제품을 보유한 회사가 출력의 다양성 문제에 직면한 것은 이번이 처음이 아닙니다. AI 이미지 합성이 대중의 눈에 띄게 되면서 DALL-E 2 2022년 4월, 사람들은 즉시 알아 차렸다 편향된 훈련 데이터로 인해 결과가 편향되는 경우가 많았습니다. 예를 들어, 비평가들은 프롬프트가 종종 인종차별적이거나 성차별적인 이미지를 낳는다고 불평했습니다(예를 들어 “CEO”는 일반적으로 백인 남성이고 “화난 사람”은 흑인 남성을 묘사하는 결과를 가져옴). 이에 대응하기 위해 OpenAI 기술을 발명했다 2022년 7월에 시스템이 다양성을 반영하는 용어 삽입 (예: “흑인”, “여성” 또는 “아시아인”)을 사용자에게 숨겨진 방식으로 이미지 생성 프롬프트로 변환합니다.

Google의 Gemini 시스템도 유사한 작업을 수행하는 것으로 보입니다. 사용자의 이미지 생성 프롬프트(예: “건국의 아버지 그림을 그려주세요”와 같은 지시)를 취하고 “남아시아인” 또는 “비인종”과 같은 인종 및 성별 다양성에 대한 용어를 삽입합니다. -binary”가 이미지 생성기 모델로 전송되기 전에 프롬프트에 추가됩니다. X에 누군가 설득했다고 주장한다 Gemini는 이 시스템이 어떻게 작동하는지 설명하며 시스템 프롬프트가 AI 모델과 어떻게 작동하는지에 대한 우리의 지식과 일치합니다. 시스템 프롬프트는 자연어 문구를 사용하여 AI 모델의 작동 방법을 알려주는 서면 지침입니다.

Meta의 “Meta AI로 상상해 보세요” 12월 이미지 생성기에서 우리는 편견에 대응하기 위한 시도로 유사한 삽입된 다양성 원칙을 발견했습니다.

논란이 커지자 지난 수요일 구글 PR 측은 “이런 종류의 묘사를 즉시 개선하기 위해 노력하고 있다”며 “제미니의 AI 이미지 생성은 정말 다양한 사람들을 생성한다. 그리고 전 세계 사람들이 사용하기 때문에 일반적으로 좋은 일”이라고 썼다. 하지만 여기에는 표시가 빠졌어요.”

이 에피소드는 AI 연구자들이 온라인에서 이데올로기적, 문화적 싸움의 한가운데에 갇혀 있는 지속적인 투쟁을 반영합니다. 서로 다른 세력은 어느 누구도 문화적 관점을 완전히 만족시키지 못한 채 AI 제품에 대해 서로 다른 결과(예: 편견 방지 또는 유지)를 요구합니다. 모든 정치적, 문화적 관점을 충족할 수 있는 모놀리식 AI 모델을 제공하는 것은 어렵고 일부 전문가는 이를 인정합니다.

“우리에게는 자유롭고 다양한 언론이 필요한 것과 같은 이유로 자유롭고 다양한 AI 비서가 필요합니다.” 썼다 Meta의 수석 AI 과학자인 Yann LeCun은 X에 대해 “X는 전 세계의 언어, 문화, 가치 체계, 정치적 견해 및 관심 중심의 다양성을 반영해야 합니다.”라고 말했습니다.

OpenAI가 2022년에 이러한 문제를 겪었을 때 다양성 삽입 기술로 인해 처음에는 어색한 세대가 있었지만 OpenAI는 Google에 비해 상대적으로 작은 회사였기 때문에 새로운 분야에 첫발을 내디뎠기 때문에 이러한 실수는 매력을 느끼지 못했습니다. 많은 관심. 시간이 지나면서 OpenAI는 시스템 프롬프트를 개선했습니다.이제 ChatGPT에 포함되어 있으며 DALL-E 3, Google이 현재 직면하고 있는 상황을 대부분 피하면서 의도적으로 출력에 다양성을 포함합니다. 여기에는 시간과 반복이 걸렸으며 Google은 동일한 시행착오 과정을 겪게 될 것입니다. 그러나 매우 큰 공개 단계에서 진행됩니다. 이를 해결하기 위해 Google은 예를 들어 프롬프트에 역사적 주제가 포함될 때 다양성을 삽입하지 않도록 시스템 지침을 수정할 수 있습니다.

수요일에 Gemini 직원인 Jack Kawczyk은 이를 인식한 것 같았고 썼다“우리는 Gemini가 일부 역사적 이미지 생성 묘사에서 부정확성을 제공하고 있다는 것을 알고 있으며, 이 문제를 즉시 수정하기 위해 노력하고 있습니다. AI 원칙의 일부로 ai.google/responsibility, 우리는 글로벌 사용자 기반을 반영하도록 이미지 생성 기능을 설계하고 표현과 편견을 심각하게 받아들입니다. 우리는 개방형 프롬프트에 대해 계속해서 이 작업을 수행할 것입니다(개와 산책하는 사람의 이미지는 보편적입니다!) 역사적 맥락은 이에 대한 더 많은 뉘앙스를 갖고 있으며 이를 수용하기 위해 추가로 조정할 것입니다. 이는 피드백을 반복하는 정렬 프로세스의 일부입니다.”